SQL - статьи

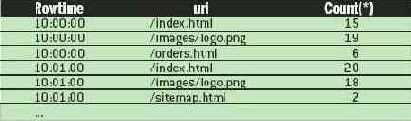

Изучение влияния числа пользователей

Для изучения влияния числа пользователей на изменение производительности СУБД рассмотрим результаты тестирования на сервере PROSERVER, обладающим наиболее мощными техническими характеристиками.Таблица 12

Анализ производительности СУБД и количество пользователей.

| Тест | U=1 | U=2 | U=3 | ||||||||||||||||

| D | P av | P max | D | P av | P max | D | P av | P max | |||||||||||

| Запрос №1 | |||||||||||||||||||

| MySQL 4.0.20 | 6290,2 ( ± 88,1) | 8,4 | 22,8 | 6217,0 ( ± 83,9) | 9,4 | 23,1 | 6831,3 ( ± 64,7) | 9,8 | 23,5 | ||||||||||

| MS SQL Server 7.0 SP4 | 19,8 ( ± 2,9) | 20,9 | 32 ,8 | 17,8 ( ± 1,9) | 3,4 | 16,4 | 18,2 ( ± 2,0) | 5,2 | 29,2 | ||||||||||

| MS SQL Server 2000 | 16,2 ( ± 0,9) | 6,4 | 15,3 | 16,2 ( ± 0,9) | 5,6 | 24,3 | 19,4 ( ± 2,8) | 13,3 | 27,7 | ||||||||||

| Запрос №2 | |||||||||||||||||||

| MySQL 4.0.20 | 196,4 ( ± 6,9) | 8,4 | 22,8 | 176,0 ( ± 7,9) | 9,4 | 23,1 | 164,7 ( ± 4,9) | 9,8 | 23,5 | ||||||||||

| MS SQL Server 7.0 SP4 | 17,0 ( ± 2,9) | 20,9 | 32,8 | 9,9 ( ± 2,6) | 3,4 | 16,4 | 24,5 ( ± 9,1) | 5,2 | 29,2 | ||||||||||

| MS SQL Server 2000 | 18,8 ( ± 3,3) | 6,4 | 15,3 | 26,0 ( ± 3,6) | 5,6 | 24,3 | 25,5 ( ± 2,8) | 13,3 | 27,7 | ||||||||||

| Запрос №3 | |||||||||||||||||||

| MySQL 4.0.20 | 116,2 ( ± 4,9) | 8,4 | 22,8 | 93,3 ( ± 4,9) | 9,4 | 23,1 | 85,8 ( ± 2,8) | 9,8 | 23,5 | ||||||||||

| MS SQL Server 7.0 SP4 | 5,3 ( ± 2,7) | 20,9 | 32,8 | 2,0 ( ± 1,9) | 3,4 | 16,4 | 6,3 ( ± 3,0) | 5,2 | 29,2 | ||||||||||

| MS SQL Server 2000 | 4,7 ( ± 2,6) | 6,4 | 15,3 | 5,2 ( ± 2,6) | 5,6 | 24,3 | 7,3 ( ± 2,8) | 13,3 | 27,7 |

Как видно из таблицы, достоверного снижения или увеличения производительности работы СУБД в зависимости от числа пользователей не отмечено. Вероятно, это объясняется искусственной природой запросов, а также высокой плотностью однотипного потока запросов к СУБД при многопользовательском режиме работы программы тестирования. Скорее всего, указанные особенности тестирования приводили к сильному влиянию кеширования результатов выполнения последних запросов, поэтому в ряде тестов отмечено даже снижение среднего времени выполнения запроса при увеличении числа пользователей. В условиях реальной работы пользователей с МИС вероятность появления одинакового запроса сразу от нескольких пользователей снижается практически до нуля. В связи с этим следует ожидать снижение эффекта влияние кеширования запросов совместно с увеличением числа пользователей. Достоверно (p=0,04 с U=1 до U=2, p=0,009 с U=2 до U=3) отмечено увеличение показателя средней загрузки процессора при увеличении числа пользователей. Менее достоверно (p=0,27) увеличивается показатель максимальной загрузки процессора при увеличении пользователей от 1 до 2. Однако уже при увеличении числа пользователей от 2 до 3 практически абсолютно достоверно (р=0,009) этот показатель увеличился.

В целом в ходе анализа результатов тестов следует отметить более экономный расход процессорных ресурсов СУБД MySQL по сравнению с СУБД MS SQL Server .

Microsoft SQL Server против MySQL в медицинских информационных системах

, к.т.н, ст. инженер-программист ОАО "Кондопога", инженер-программист ОАО "Кондопога"

Проектирование и разработка комплексной медицинской информационной системы (КМИС) – сложный, трудоемкий и дорогостоящий процесс. Известно, что в настоящее время в России себестоимость создания КМИС зачастую выше, чем реальная цена, по которой ее можно распространять. Поэтому поиск решений, снижающих сложность и трудоемкость процесса проектирования и практической разработки КМИС, является в настоящее время одной их приоритетных задач разработчиков, занятых в такой специфичной области, как медицина. Существует множество различных подходов для решения этой задачи, но пока говорить о безусловной приоритетности какого-то одного из них еще рано, т.к. комплексные информационные решения в медицинских учреждениях все еще являются скорее исключением, чем правилом. Остановимся на отдельном аспекте в проектировании КМИС, который, по нашему мнению, является основополагающим – это выбор системы управления базами данных (СУБД). Отметим, что, по нашим данным, с использованием СУБД на архитектуре «Клиент-Сервер» построено 71% всех известных нам медицинских информационных системы, эта доля продолжает увеличиваться.

На сегодня можно выделить 3 основных подхода в вопросе выбора СУБД:

1. КМИС разрабатывается на базе реляционной СУБД. Этот подход используется в подавляющем большинстве решений («Амулет», «Медкор-2000», « Medwork », «Дока+» и др.)

2. КМИС разрабатывается на базе пост-реляционной СУБД или объектно-ориентированной СУБД. Этот подход чаще всего используется при выборе СУБД Cache или Lotus Notes / Domino в качестве основы системы («Гиппократ», «MedTrak», «LabTrak»)

3. Объектно-реляционный подход. По нашему мнению [], это наиболее перспективное решение, учитывающее специфику предметной области и, вместе с тем, интегрирующее в себе все преимущества первых двух решений («Интерин», «ИС Кондопога»).

Выбор конкретной СУБД представляет собой сложную многопараметрическую задачу и является одним из важнейших этапов в разработке медицинской информационной системы. Выбранный программный продукт должен удовлетворять как текущим, так и будущим потребностям лечебно-профилактического учреждения (ЛПУ), при этом следует учитывать финансовые затраты на приобретение необходимого оборудования, самой системы, разработку необходимого программного обеспечения на ее основе, а также обучение персонала. [].

Очевидно, наиболее простой подход при выборе СУБД основан на оценке того, в какой мере существующие системы удовлетворяют основным требованиям создаваемого проекта информационной системы. Более сложным и дорогостоящим вариантом является создание испытательного проекта на основе нескольких СУБД и последующий выбор наиболее подходящего из кандидатов. Но, и в этом случае необходимо ограничивать круг возможных систем, опираясь на некие критерии отбора.

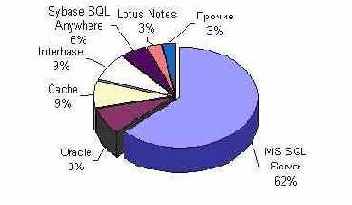

При разработке отечественных КМИС в основном применяются следующие СУБД: Oracle, IBM DB 2 и Informix, Borland Interbase Server, MS SQL Server, Cache, Lotus Notes / Domino, MySQL и некоторые другие. Преимущественно используется СУБД Microsoft SQL Server, чья доля составляет 62% (Рис. 1).

Рис. 1 . Соотношение СУБД на архитектуре «Клиент-сервер» в отечественных медицинских информационных системах

IBM и Oracle заслуженно считаются лидерами в области систем управления БД. Специалисты IBM первыми ввели понятие реляционных БД и разработали SQL. К достижениям Oracle (вне рынка мэйнфреймов) можно отнести выпуск первой коммерческой СУБД, поддерживающей SQL (1979), первой клиент-серверной версии (1987), первой 32-разрядной (1983) и 64-разрядной (1995) версий, а также первой коммерческой СУБД, перенесенной на Linux (1999) []. Вместе с тем, в медицинской предметной области все чаще предпочтение отдается Microsoft SQL Server, возможно в силу хорошей маркетинговой политике Microsoft и более простой процедуре установки и меньшей стоимости владения.

Практически все из перечисленных коммерческих СУБД являются достаточно дорогими программными продуктами. Их использование в процессе проектирования и разработки само по себе имеет значительную долю в себестоимости КМИС. Кроме того, наметившаяся в последнее время тенденция к повышению престижности и потребности в лицензионном программном обеспечении повышает общую стоимость внедрения КМИС. Это обусловлено тем, что еще пару лет назад главный врач ЛПУ, решившийся на внедрение КМИС у себя в клинике и обладающий определенной (при этом весьма ограниченной) суммой, решал главным образом два вопроса: какую КМИС выбрать и сколько необходимо компьютерной техники. Сейчас все чаще мы видим ситуацию, когда к этим двум вопросам добавляется третий: сколько необходимо лицензионного программного обеспечения?

Все вышесказанное является естественным стимулом для поиска более доступных по цене СУБД и обладающих, вместе с тем, достаточным запасом функциональности и производительности. И такое решение имеется – это использование в качестве платформы разработки КМИС продуктов Open Source, главным образом – СУБД MySQL (или ряда других, менее известных, но не менее доступных решений).

В связи с этим мы поставили себе целью на практике изучить двух наиболее ярких представителей СУБД и выяснить, какие преимущества и недостатки имеют коммерческие и свободно-распространяемые СУБД в медицинской предметной области. При этом в качестве образца коммерческой СУБД мы выбрали программное обеспечение Microsoft SQL Server версий 7.0 и 2000, а в качестве свободно-распространяемой СУБД мы выбрали MySQL версии 4.0.21.

Данное исследование выполнялось нами в течение 2004 г. на базе разработанной на основе объектно-реляционного подхода комплексной медицинской информационной системы "Кондопога". Основу системы составляет документно-ориентированное ядро, созданное на СУБД Lotus Domino . При этом небольшую часть системы, предназначенную для функционирования некоторых задач статистики и бухгалтерии, составляет реляционная база данных. Используется специально разработанная технология "вариабельного ядра" (http://iskondopoga.narod.ru/ sience/ files/ 2004/ auto_gus.pdf), в задачи которой входит автоматическое связывание и масштабирование интегрированной объектно-реляционной БД []. В качестве СУБД мы апробировали вначале MySQL, а затем Microsoft SQL Server. При этом для нас очень важным был обоснованный выбор какой-то конкретной СУБД, с необходимым обоснованием и анализом результатов практической эксплуатации обоих СУБД и оценкой результатов этих эксплуатаций. Для этого мы выполнили ряд специальных тестов, изучали удобство в развертывании, администрировании и эксплуатации, оценивали устойчивость и другие параметры.

В качестве сценария для оценки этих СУБД мы использовали статью А. Аносова «» []. В ней предлагается анализировать СУБД по ряду признаков, объединенных в общие разделы. На основе анализа этих признаков предлагается решать вопрос о приоритетности каждой конкретной СУБД для выбранной предметной области. Даже если просто отмечать, насколько хороши или плохи выделенные параметры в случае каждой конкретной СУБД, то сравнение уже двух различных систем является трудоемкой задачей. Тем не менее, четкий и глубокий сравнительный анализ на основании вышеперечисленных критериев в любом случае поможет рационально выбрать подходящую систему для конкретного проекта, и затраченные усилия не будут напрасными. Перечень критериев поможет осознать масштабность задачи и выполнить ее адекватную постановку

Рассмотрим результаты исследования. Для этого процитируем важнейшие из предложенных А.Аносовым показателей и прокомментируем их особенности для КМИС.

1. Триггеры и хранимые процедуры. Триггер – программа базы данных, вызываемая всякий раз при вставке, изменении или удалении строки таблицы. Триггеры обеспечивают проверку любых изменений на корректность, прежде чем эти изменения будут приняты. Хранимая процедура – программа, которая хранится на сервере и может вызываться клиентом. Поскольку хранимые процедуры выполняются непосредственно на сервере базы данных, обеспечивается более высокое быстродействие, нежели при выполнении тех же операций средствами клиента БД. В различных программных продуктах для реализации триггеров и хранимых процедур используются различные инструменты.

MySQL версии 4.0.21, в отличии от Microsoft SQL Server, не поддерживает ни триггеры, ни хранимые процедуры, что значительно усложняет ее использование, т.к. в приложениях системы большую часть необходимых проверок введенных данных и всевозможных блокировок, а также обеспечение целостности базы данных приходится выполнять на уровне клиентского приложения, что очень усложняет процесс создания и эксплуатации КМИС.

2. Особенности разработки приложений. Многие производители СУБД выпускают средства разработки приложений для своих систем. Как правило, эти средства позволяют наилучшим образом реализовать все возможности сервера, поэтому при анализе СУБД стоит рассмотреть также возможности средств разработки приложений.

Таблица 1

Особенности разработки приложений

| Показатель | MS SQL Server | MySQL |

| Визуальные средства проектирования | + | + |

| Многоязыковая поддержка | + | + |

| Возможности разработки web -приложений | + | + |

| Поддержка JAVA | + | |

| Встроенный язык программирования | + | |

| Data Mining | + |

3. Перечень операционных систем, под управлением которых способна работать СУБД. В этом разделе, безусловно, лидирует MySQL, которая способна работать на большинстве из имеющихся на настоящее время операционных систем. Некоторые из них имеют значительно более низкую стоимость, чем продукты фирмы Microsoft, что, конечно, ведет к снижению затрат при внедрении КМИС.

Таблица 2

Поддерживаемые операционные системы.

| Показатель | ОС |

| MS SQL Server | Windows NT,2000 (Intel и Alpha) |

| MySQL | Linux (x86, libc6,S/390,IA64, Alpha, Sparc), Windows 95/98/NT/2000/XP, Solaris 2.9 (Sparc, 64-bit, 32-bit), FreeBSD 4.x ELF (x86), Mac OS X v10.2, HP-UX 10.20 (RISC 1.0), HP-UX 11.11 (PA-RISC 1.1 или 2.0), AIX 5.1 (RS6000), QNX 6.2.0 (x86), Novell NetWare 6 (x86), SCO OpenUnix 8.0 (x86), м SGI Irix 6.5, Dec OSF 5.1 (Alpha) |

Как видно из таблицы ниже, а также по нашему опыту, требования к технической характеристике сервера у MySQL значительно ниже, чем у Microsoft SQL Server. За счет этого стоимость внедрения КМИС может быть в некоторой степени снижена.

Таблица 3

Минимальные требования к серверу.

| Показатель | ОС |

| MS SQL Server | Pentium II 350 MHz , ОЗУ – 128 Мбайт, HDD - 250 Мбайт |

| MySQL | Pentium 100 MHz , ОЗУ - 64 Мбайт (минимум), 100 Мбайт свободного места на диске |

Таблица 4

Примерная стоимость СУБД для 30 подключений

| Название СУБД | Цена, $ | Кол-во | Стоимость, $ |

| SQL Server 2000 Enterprise Edition English OpenLicensePack B * | 6643,97 | 1 | 6643,97 |

| SQL Server 2000 ClientAccessLicense English OpenLicensePack B* | 151,94 | 30 | 4558,2 |

| Всего на использование SQL Server 2000 | 11202,17 | ||

| MySQL Pro 10..49 licenses** | 315 | 1 | 315 |

** - по данным сайта http :// www . mysql . com на апрель 2003 г .

5. Производительность. Рассмотрим подробнее результаты исследования производительности различных СУБД, т.к. этот показатель является одним из основных факторов, влияющих на качество работы КМИС. При этом изучались 2 версии Microsoft SQL Server: версия 7.0 с установленным пакетом исправлений и дополнений Service Pack 4, а также версия 2000. После установки каждой СУБД на ней встроенными средствами администрирования создавалась база данных R _ TEST _ DB, в которую помещалась одна таблица с именем LVN, содержащая 65 столбцов и 20 098 строк записей. Объем таблицы 74,06 Мбайт (в формате MyISAM). В этой таблице находилась реальная информация о выданных больничных листах в одном из медицинских учреждений Карелии в период с 2-го полугодия 2002 по первое полугодие 2004 г. (24 месяца). Таблица помещалась в указанную БД во всех тестах при помощи средства DataPump, входящего в состав пакета программ Borland Delphi 6 Professional. В исследовании участвовали 3 сервера, технические характеристики которых представлены в таблице ниже.

Таблица 5

Технические характеристики серверов, участвовавших в тестировании:

| № | NetBios -имя сервера | Техническая характеристика |

| 1 | POLIKSERVER | Asus P4800Delux / P4 3,06 GHz / RAM 2 x 512 Mb DDR400 / HDD 120 Gb 7200 prn |

| 2 | SRV2 | 2 x 500 MHz Pentium III Xeon / RAM 1 Gb / RAID 5 24 Gb SCSI-160 |

| 3 | PROSERVER | 2 x 3,06 GHz Pentium 4 Xeon HT / RAM 2 Gb / RAID 5 102 Gb SCSI-320 |

Таблица 6

Технические характеристики рабочих станций,

участвовавших в тестировании:

№ |

NetBios -имя ПК |

Техническая характеристика |

1 |

Admin |

Asus P4533 / P4 1,5 MHz / RAM 512 Mb DDR333 / HDD 40 Gb 7200 prn |

2 |

Admin2 |

Asus P4800Delux / P4 3,06 GHz / RAM 2 x 512 Mb DDR400 / HDD 120 Gb 7200 prn |

3 |

Admin7 |

Asus P4533 / P4 1,5 MHz / RAM 512 Mb DDR333 / HDD 40 Gb 7200 prn |

В данном исследовании было выбрано 3 наиболее показательных вида SQL -запроса, тексты которых представлены в таблице ниже.

Таблица 7

SQL -запросы, выполнявшиеся в ходе тестирования

№ |

Название запроса |

SQL запрос |

1 |

Простой Select |

S ELECT * FROM lvn |

2 |

Вывод отчета по строкам статистики |

SELECT UNWORKSTATLINE1, COUNT(UNWORKSTATLINE1), SUM(CNUMKOIKOD) FROM lvn GROUP BY UNWORKSTATLINE1 |

3 |

Среднее количество суток по группам возрастов |

SELECT CNUMVOZRAST, AVG(VOZRAST) FROM lvn GROUP BY CNUMVOZRAST |

В таблицах с результатами исследований используются следующие переменные:

U – количество пользователей;

P av – средняя загрузка процессора(ов);

P max – максимальная загрузка процессора(ов);

D – длительность выполнения запроса, мсек.

В таблицах ниже представлены результаты выполнения запросов №1, 2 и 3. В приложении приведена исходная таблица с результатами выполнения тестов.

Таблица 8

Результаты выполнения запроса №1

| Тест | U=1 | U=2 | U=3 | ||||||

| D | P av | P max | D | P av | P max | D | P av | P max | |

|

POLIKSERVER + MySQL 4.020 |

5450,8 ( ± 66,5) |

14,3 | 46,88 |

5608,2 ( ± 71,8) |

28,8 | 64,3 |

6011,4 ( ± 68,0) |

41,3 | 62,2 |

|

POLIKSERVER + MS SQL Server 7.0 SP4 |

15,7 ( ± 0,2) |

30 ,1 | 92 |

14,1 ( ± 1,7) |

73,5 | 100 |

13,6 ( ± 1,9) |

97 | 100 |

|

POLIKSERVER + MS SQL Server 2000 |

16,2 ( ± 1,0) |

7,5 | 32,8 |

17,7 ( ± 2,4) |

21,2 | 43,7 |

19,3 ( ± 2,7) |

18,9 | 67,1 |

|

SRV2 + MySQL 4.0.20 |

6304,3 ( ± 38,3) |

28 | 51 |

6273,4 ( ± 23,2) |

63 | 98 |

6222,9 ( ± 50,9) |

86 | 100 |

|

SRV2 + MS SQL Server 7.0 SP4 |

19,2 ( ± 2,7) |

10,3 | 30,4 |

18,2 ( ± 2,1) |

19,2 | 55,5 |

32,4 ( ± 5,8) |

14 | 77,3 |

|

SRV2 + MS SQL Server 2000 |

19,4 ( ± 2,3) |

22,9 | 42,9 |

19,8 ( ± 2,8) |

41 ,4 | 84,3 |

28,7 ( ± 14,1) |

26,8 | 74,9 |

|

PROSERVER + MySQL 4.0.20 |

6290,2 ( ± 88,1) |

8,4 | 22,8 |

6217,0 ( ± 83,9) |

9,4 | 23,1 |

6831,3 ( ± 64,7) |

9,8 | 23,5 |

|

PROSERVER + MS SQL Server 7.0 SP4 |

19,8 ( ± 2,9) |

20,9 | 32,8 |

17,8 ( ± 1,9) |

3,4 | 16,4 |

18,2 ( ± 2,0) |

5,2 | 29,2 |

|

PROSERVER + MS SQL Server 2000 |

16,2 ( ± 0,9) |

6,4 | 15,3 |

16,2 ( ± 0,9) |

5,6 | 24,3 |

19,4 ( ± 2,8) |

13,3 | 27,7 |

Результаты выполнения запроса №2

| Тест | U=1 | U=2 | U=3 | ||||||

| D | P av | P max | D | P av | P max | D | P av | P max | |

|

POLIKSERVER + MySQL 4.020 |

163,0 ( ± 3,2) |

14,3 | 46,88 |

155,3 ( ± 4,0) |

28,8 | 64,3 |

153,7 ( ± 14,5) |

41,3 | 62,2 |

|

POLIKSERVER + MS SQL Server 7.0 SP4 |

153 ,3 ( ± 10,9) |

30,1 | 92 |

233,9 ( ± 21,7) |

73,5 | 100 |

340,8 ( ± 20,3) |

97 | 100 |

|

POLIKSERVER + MS SQL Server 2000 |

17,1 ( ± 1,6) |

7,5 | 32,8 |

27,0 ( ± 13,9) |

21,2 | 43,7 |

18,2 ( ± 2,1) |

18,9 | 67,1 |

|

SRV2 + MySQL 4.0.20 |

928,8 ( ± 5,4) |

28 | 51 |

961,8 ( ± 11,0) |

63 | 98 |

1276,1 ( ± 75,9) |

86 | 100 |

|

SRV2 + MS SQL Server 7.0 SP4 |

26,1 ( ± 7,1) |

10,3 | 30,4 |

31,8 ( ± 1,0) |

19,2 | 55,5 |

33,8 ( ± 3,6) |

14 | 77,3 |

|

SRV2 + MS SQL Server 2000 |

93,4 ( ± 6,7) |

22,9 | 42,9 |

92,4 ( ± 2,2) |

41,4 | 84,3 |

97,9 ( ± 8,0) |

26,8 | 74 ,9 |

|

PROSERVER + MySQL 4.0.20 |

196,4 ( ± 6,9) |

8,4 | 22,8 |

176,0 ( ± 7,9) |

9,4 | 23,1 |

164,7 ( ± 4,9) |

9,8 | 23,5 |

|

PROSERVER + MS SQL Server 7.0 SP4 |

17,0 ( ± 2,9) |

20,9 | 32,8 |

9,9 ( ± 2,6) |

3,4 | 16,4 |

24,5 ( ± 9,1) |

5,2 | 29,2 |

|

PROSERVER + MS SQL Server 2000 |

18,8 ( ± 3,3) |

6,4 | 15,3 |

26,0 ( ± 3,6) |

5,6 | 24,3 |

25,5 ( ± 2,8) |

13,3 | 27,7 |

Таблица 10

Результаты выполнения запроса №3

| Тест | U=1 | U=2 | U=3 | ||||||

| D | P av | P max | D | P av | P max | D | P av | P max | |

|

POLIKSERVER + MySQL 4.020 |

89,0 ( ± 2,9) |

14,3 | 46,88 |

85,3 ( ± 9,4) |

28,8 | 64,3 |

68,3 ( ± 2,7) |

41,3 | 62,2 |

|

POLIKSERVER + MS SQL Server 7.0 SP4 |

58,9 ( ± 3,4) |

30,1 | 92 |

85,5 ( ± 7,6) |

73,5 | 100 |

172,3 ( ± 19,9) |

97 | 100 |

|

POLIKSERVER + MS SQL Server 2000 |

3,2 ( ± 2,3) |

7,5 | 32,8 |

5,7 ( ± 2,7) |

21,2 | 43,7 |

9,9 ( ± 2,7) |

18,9 | 67,1 |

|

SRV2 + MySQL 4.0.20 |

630,9 ( ± 5,8) |

28 | 51 |

640,6 ( ± 24,2) |

63 | 98 |

933,9 ( ± 78,4) |

86 | 100 |

|

SRV2 + MS SQL Server 7.0 SP4 |

8,2 ( ± 3,1) |

10,3 | 30,4 |

10,3 ( ± 2,6) |

19,2 | 55,5 |

11,0 ( ± 4,4) |

14 | 77,3 |

|

SRV2 + MS SQL Server 2000 |

17,7 ( ± 1,9) |

22,9 | 42,9 |

16,1 ( ± 1,0) |

41,4 | 84,3 |

22,3 ( ± 6,4) |

26,8 | 74,9 |

|

PROSERVER + MySQL 4.0.20 |

116,2 ( ± 4,9) |

8,4 | 22,8 |

93,3 ( ± 4,9) |

9,4 | 23,1 |

85,8 ( ± 2,8) |

9,8 | 23,5 |

|

PROSERVER + MS SQL Server 7.0 SP4 |

5,3 ( ± 2,7) |

20,9 | 32,8 |

2,0 ( ± 1,9) |

3,4 | 16,4 |

6,3 ( ± 3,0) |

5,2 | 29,2 |

|

PROSERVER + MS SQL Server 2000 |

4,7 ( ± 2,6) |

6,4 | 15,3 |

5,2 ( ± 2,6) |

5,6 | 24,3 |

7,3 ( ± 2,8) |

13,3 | 27,7 |

Общее сравнение производительности СУБД

Таблица 11Анализ производительности СУБД по различным видам запросов (для U=1)

| СУБД | POLIKSERVER | SRV2 | PROSERVER | ||||||||||||||||

| D | P av | P max | D | P av | P max | D | P av | P max | |||||||||||

| Запрос №1 | |||||||||||||||||||

| MySQL 4.020 | 5450,8 ( ± 66,5) | 14,3 | 46,88 | 6304,3 ( ± 38,3) | 28 | 51 | 6290,2 ( ± 88,1) | 8,4 | 22,8 | ||||||||||

| MS SQL Server 7.0 SP4 | 15,7 ( ± 0,2) | 30 ,1 | 92 | 19,2 ( ± 2,7) | 10,3 | 30,4 | 19,8 ( ± 2,9) | 20,9 | 32 ,8 | ||||||||||

| MS SQL Server 2000 | 16,2 ( ± 1,0) | 7,5 | 32,8 | 19,4 ( ± 2,3) | 22,9 | 42,9 | 16,2 ( ± 0,9) | 6,4 | 15,3 | ||||||||||

| Запрос №2 | |||||||||||||||||||

| MySQL 4.020 | 163,0 ( ± 3,2) | 14,3 | 46,88 | 928,8 ( ± 5,4) | 28 | 51 | 196,4 ( ± 6,9) | 8,4 | 22,8 | ||||||||||

| MS SQL Server 7.0 SP4 | 153 ,3 ( ± 10,9) | 30,1 | 92 | 26,1 ( ± 7,1) | 10,3 | 30,4 | 17,0 ( ± 2,9) | 20,9 | 32,8 | ||||||||||

| MS SQL Server 2000 | 17,1 ( ± 1,6) | 7,5 | 32,8 | 93,4 ( ± 6,7) | 22,9 | 42,9 | 18,8 ( ± 3,3) | 6,4 | 15,3 | ||||||||||

| Запрос №3 | |||||||||||||||||||

| MySQL 4.020 | 89,0 ( ± 2,9) | 14,3 | 46,88 | 630,9 ( ± 5,8) | 28 | 51 | 116,2 ( ± 4,9) | 8,4 | 22,8 | ||||||||||

| MS SQL Server 7.0 SP4 | 58,9 ( ± 3,4) | 30,1 | 92 | 8,2 ( ± 3,1) | 10,3 | 30,4 | 5,3 ( ± 2,7) | 20,9 | 32,8 | ||||||||||

| MS SQL Server 2000 | 3,2 ( ± 2,3) | 7,5 | 32,8 | 17,7 ( ± 1,9) | 22,9 | 42,9 | 4,7 ( ± 2,6) | 6,4 | 15,3 |

Как видно из таблицы, очень сильное влияние на результаты тестов оказывает используемый сервер. Наиболее сильно расходятся результаты в случае использования 2-х процессорных серверов (SRV 2 и PROSERVER). В случае использования обычной рабочей станции POLIKSERVER в качестве сервера для реляционной СУБД результаты менее отличаются. Так, выполнение запроса №3 осуществляется MySQL на 51,1% медленнее, чем MS SQL Server 7.0 на сервере POLIKSERVER. Применение сервера SRV 2 демонстрирует снижение производительности MySQL в 76,9 раза. Исходя из этого, можно сделать вывод о том, что СУБД MS SQL Server более эффективно использует серверную платформу, причем независимо от версии. В наиболее благоприятных технических условиях СУБД MySQL выполняет запрос №1 в 347,2 раза медленнее, чем СУБД MS SQL Server 7.0. Запрос №2 выполняется MySQL лишь на 6,3% медленнее. Запрос №3 выполняется на 51,1% медленнее. В случае использования последних версий серверов ( PROSERVER ) MySQL выполняет запрос №1 в 317,7 раза медленнее, чем СУБД MS SQL Server 7.0. Запрос №2 выполняется MySQL в 11,6 раза медленнее. Запрос №3 выполняется в 21,9 раза медленнее. Таким образом, необходимо сделать вывод о том, что практически по всем видам запросов СУБД MS SQL Server выполняет их значительно быстрее, причем эта разница возрастает в случае применения настоящих серверных платформ, особенно – последних версий.

Исходные результаты выполнения тестов СУБД

Исходные данные тестирования СУБДТаблица 13

Исходные результаты выполнения тестов СУБД и серверов

| Код | Код теста | Код SQL -запроса | U | P max | P av | D | Ст.откл. | Дисперс. |

| 1 | 1 | 1 | 1 | 46,88 | 14,3 | 5450,8 | 185,70952 | 66,4553 |

| 1 | 1 | 2 | 1 | 46,88 | 14,3 | 163,03333 | 8,86748 | 3,17319 |

| 1 | 1 | 3 | 1 | 46,88 | 14,3 | 89,03333 | 8,14241 | 2,91373 |

| 2 | 1 | 1 | 2 | 64,28 | 28,8 | 5608,23333 | 200,64125 | 71,79855 |

| 2 | 1 | 2 | 2 | 64,28 | 28,8 | 155,3 | 11,35826 | 4,0645 |

| 2 | 1 | 3 | 2 | 64,28 | 28,8 | 85,3 | 26,547 | 9,49972 |

| 3 | 1 | 1 | 3 | 62,2 | 41,3 | 6011,43333 | 190,11815 | 68,03291 |

| 3 | 1 | 2 | 3 | 62,2 | 41,3 | 153,66667 | 40,49307 | 14,49026 |

| 3 | 1 | 3 | 3 | 62,2 | 41,3 | 68,33333 | 7,57775 | 2,71166 |

| 4 | 2 | 1 | 1 | 92 | 30,1 | 15,67742 | 0,46746 | 0,16456 |

| 4 | 2 | 2 | 1 | 92 | 30,1 | 153,53333 | 30,39488 | 10,87667 |

| 4 | 2 | 3 | 1 | 92 | 30,1 | 58,96667 | 9,63495 | 3,44782 |

| 5 | 2 | 1 | 2 | 100 | 73,5 | 14,13333 | 4,73099 | 1,69296 |

| 5 | 2 | 2 | 2 | 100 | 73,5 | 233,86667 | 60,74742 | 21,73818 |

| 5 | 2 | 3 | 2 | 100 | 73,5 | 85,46667 | 21,17189 | 7,57626 |

| 6 | 2 | 1 | 3 | 100 | 97 | 13,63333 | 5,36335 | 1,91925 |

| 6 | 2 | 2 | 3 | 100 | 97 | 340,8 | 56,78814 | 20,32138 |

| 6 | 2 | 3 | 3 | 100 | 97 | 172,33333 | 55,49134 | 19,85732 |

| 7 | 3 | 1 | 1 | 51 | 28 | 6304,33333 | 107,14798 | 38,34241 |

| 7 | 3 | 2 | 1 | 51 | 28 | 928,76667 | 15,14966 | 5,42124 |

| 7 | 3 | 3 | 1 | 51 | 28 | 630,96667 | 16,11931 | 5,76822 |

| 8 | 3 | 1 | 2 | 98 | 63 | 6273,36667 | 64,86164 | 23,21044 |

| 8 | 3 | 2 | 2 | 98 | 63 | 961,8 | 30,92615 | 11,06678 |

| 8 | 3 | 3 | 2 | 98 | 63 | 640,63333 | 67,54578 | 24,17095 |

| 9 | 3 | 1 | 3 | 100 | 86 | 6622,86667 | 142,33429 | 50,93367 |

| 9 | 3 | 2 | 3 | 100 | 86 | 1276,13333 | 212,0303 | 75,87407 |

| 9 | 3 | 3 | 3 | 100 | 86 | 933,96667 | 219,14736 | 78,42088 |

| 10 | 4 | 1 | 1 | 22,8 | 8,4 | 6290,2 | 246,26184 | 88,12367 |

| 10 | 4 | 2 | 1 | 22,8 | 8,4 | 196,4 | 19,33667 | 6,91954 |

| 10 | 4 | 3 | 1 | 22,8 | 8,4 | 116,16667 | 13,70908 | 4,90573 |

| 11 | 4 | 1 | 2 | 23,1 | 9,4 | 6217,03333 | 234,53578 | 83,92755 |

| 11 | 4 | 2 | 2 | 23,1 | 9,4 | 176,03333 | 21,99012 | 7,86906 |

| 11 | 4 | 3 | 2 | 23,1 | 9,4 | 93,3 | 13,76989 | 4,92749 |

| 12 | 4 | 1 | 3 | 23,5 | 9,8 | 6831,26667 | 180,6955 | 64,66105 |

| 12 | 4 | 2 | 3 | 23,5 | 9,8 | 164,66667 | 13,81143 | 4,94236 |

| 12 | 4 | 3 | 3 | 23,5 | 9,8 | 85,83333 | 7,71182 | 2,75964 |

| 13 | 5 | 1 | 1 | 32,8 | 20,9 | 19,76667 | 8,07747 | 2,89049 |

| 13 | 5 | 2 | 1 | 32,8 | 20,9 | 17,06667 | 8,35836 | 2,991 |

| 13 | 5 | 3 | 1 | 32,8 | 20,9 | 5,26667 | 7,45177 | 2,66658 |

| 14 | 5 | 1 | 2 | 16,4 | 3,4 | 17,76667 | 5,50565 | 1,97017 |

| 14 | 5 | 2 | 2 | 16,4 | 3,4 | 9,9 | 7,54255 | 2,69907 |

| 14 | 5 | 3 | 2 | 16,4 | 3,4 | 2,03333 | 5,18641 | 1,85593 |

| 15 | 5 | 1 | 3 | 29,2 | 5,2 | 18,23333 | 5,72529 | 2,04877 |

| 15 | 5 | 2 | 3 | 29,2 | 5,2 | 24,5 | 25,4673 | 9,11336 |

| 15 | 5 | 3 | 3 | 29,2 | 5,2 | 6,26667 | 8,66 | 3,09894 |

| 16 | 6 | 1 | 1 | 30,4 | 10,3 | 19,23333 | 7,70577 | 2,75747 |

| 16 | 6 | 2 | 1 | 30,4 | 10,3 | 26,13333 | 19,90433 | 7,12267 |

| 16 | 6 | 3 | 1 | 30,4 | 10,3 | 8,23333 | 8,68594 | 3,10822 |

| 17 | 6 | 1 | 2 | 55,5 | 19,2 | 18,23333 | 5,90866 | 2,11439 |

| 17 | 6 | 2 | 2 | 55,5 | 19,2 | 31,83333 | 2,85287 | 1,02089 |

| 17 | 6 | 3 | 2 | 55,5 | 19,2 | 10,33333 | 7,31817 | 2,61877 |

| 18 | 6 | 1 | 3 | 77,3 | 14 | 32,4 | 16,08436 | 5,75571 |

| 18 | 6 | 2 | 3 | 77,3 | 14 | 33,76667 | 9,96221 | 3,56493 |

| 18 | 6 | 3 | 3 | 77,3 | 14 | 11 | 12,29634 | 4,40019 |

| 19 | 7 | 1 | 1 | 32,8 | 7,5 | 16,16667 | 2,97863 | 1,06589 |

| 19 | 7 | 2 | 1 | 32,8 | 7,5 | 17,13333 | 4,64567 | 1,66243 |

| 19 | 7 | 3 | 1 | 32,8 | 7,5 | 3,2 | 6,4 | 2,29021 |

| 20 | 7 | 1 | 2 | 43,7 | 21,2 | 17,73333 | 6,5774 | 2,35369 |

| 20 | 7 | 2 | 2 | 43,7 | 21,2 | 27,03333 | 38,80248 | 13,88529 |

| 20 | 7 | 3 | 2 | 43,7 | 21,2 | 5,73333 | 7,5407 | 2,69841 |

| 21 | 7 | 1 | 3 | 67,1 | 18,9 | 19,26667 | 7,62423 | 2,7283 |

| 21 | 7 | 2 | 3 | 67,1 | 18,9 | 18,2 | 5,83324 | 2,0874 |

| 21 | 7 | 3 | 3 | 67,1 | 18,9 | 9,93333 | 7,56718 | 2,70788 |

| 22 | 8 | 1 | 1 | 15,3 | 6,4 | 16,2 | 2,78568 | 0,99684 |

| 22 | 8 | 2 | 1 | 15,3 | 6,4 | 18,76667 | 9,31194 | 3,33223 |

| 22 | 8 | 3 | 1 | 15,3 | 6,4 | 4,7 | 7,18401 | 2,57076 |

| 23 | 8 | 1 | 2 | 24,3 | 5,6 | 16,2 | 2,78568 | 0,99684 |

| 23 | 8 | 2 | 2 | 24,3 | 5,6 | 26,03333 | 10,13076 | 3,62524 |

| 23 | 8 | 3 | 2 | 24,3 | 5,6 | 5,2 | 7,35935 | 2,63351 |

| 25 | 8 | 1 | 3 | 27,7 | 13,3 | 19,36667 | 7,7781 | 2,78336 |

| 25 | 8 | 2 | 3 | 27,7 | 13,3 | 25,5 | 7,79637 | 2,78989 |

| 25 | 8 | 3 | 3 | 27,7 | 13,3 | 7,33333 | 7,84573 | 2,80756 |

| 26 | 9 | 1 | 1 | 42,9 | 22,9 | 19,4 | 6,48896 | 2,32205 |

| 26 | 9 | 2 | 1 | 42,9 | 22,9 | 93,36667 | 18,75897 | 6,71281 |

| 26 | 9 | 3 | 1 | 42,9 | 22,9 | 17,73333 | 5,32249 | 1,90463 |

| 27 | 9 | 1 | 2 | 84,3 | 41,4 | 19,8 | 7,99333 | 2,86038 |

| 27 | 9 | 2 | 2 | 84,3 | 41,4 | 92,36667 | 6,07993 | 2,17568 |

| 27 | 9 | 3 | 2 | 84,3 | 41,4 | 16,1 | 2,80891 | 1,00516 |

| 28 | 9 | 1 | 3 | 74,9 | 26,8 | 28,73333 | 39,54823 | 14,15215 |

| 28 | 9 | 2 | 3 | 74,9 | 26,8 | 97,86667 | 22,45103 | 8,034 |

| 28 | 9 | 3 | 3 | 74,9 | 26,8 | 22,3 | 17,93349 | 6,41742 |

Выводы по выбору СУБД с учетом анализа производительности

По результатам этого исследования, разумеется, нельзя однозначно судить о приоритете СУБД MS SQL Server над MySQL. В ходе эксплуатации различных подсистем в составе нашей медицинской информационной системы, использующих реляционную базу данных на основе СУБД MySQL мы отмечали достаточно высокую производительность на гораздо больших объемах данных. Для ее достижения применялись стандартные методы проектирования реляционной БД, целочисленные поля в качестве ключей для связанных таблиц и т.д. Однако изучение результатов, полученных в данном тестировании, позволяет сделать вывод о значительно более высокой скорости работы СУБД MS SQL Server, как наиболее распространенного представителя коммерческих СУБД. Кроме того, следует отметить выдающиеся возможности администрирования и обслуживания СУБД MS SQL Server. Аналогичные по функциональном назначению средства, имеющиеся для СУБД MySQL, значительно уступают в своих возможностях средствам MS SQL Server. Кроме этого, имеющиеся на сайте MySQL на лето 2004 программы для управления СУБД имели низкую устойчивость в работе, а в ряде случаев – вообще не выполняли тех функций, которые декларировали. Однако не следует забывать, что СУБД MySQL – полностью бесплатный продукт, готовый к использованию на абсолютно законных основаниях (если Вы только не собираетесь распространять решения, основные на этом продукте на коммерческой основе). Анализируя все вышесказанное, можно сделать вывод о том, что в настоящее время решающую роль в медицинской предметной области может играть не какие-то конкретные параметры СУБД, такие как устойчивость или производительность, а совсем другие, относящиеся скорее к сфере субъектных моментов. Основные из них – это доступность технической поддержки, регулярность появления новых версий и выпуска т.н. пакетов исправлений, наличие (в том числе в сети Internet) русскоязычной и подробной документации, профессионализм разработчиков.В качестве рекомендаций мы сформировали следующее правило: если коллектив разработчиков обладает достаточными финансовыми возможностями и если Ваши потенциальные заказчики также способны приобрести необходимое количество лицензий, следует отдавать безусловное предпочтение коммерческим СУБД, таким как Microsoft SQL Server. Если финансовые возможности как разработчика, так и потребителя информационной системы ограничены, следует выбрать СУБД MySQL, которая обладает достаточным уровнем устойчивости работы и приемлемой за свою стоимость производительностью.

Следует отметить, что по существующей практике решение об использовании той или иной СУБД принимает чаще один человек – обычно, руководитель проекта, а он может опираться отнюдь не на технические критерии. Здесь свою роль могут сыграть такие, с технической точки зрения, незначительные факторы, как рекламная раскрутка компании-производителя СУБД, использование конкретных систем на других предприятиях, стоимость. При этом последний фактор может трактоваться в двух противоположных смыслах в зависимости от финансового состояния и политики ЛПУ. С одной стороны это может быть принцип «если дороже, то значит - лучше». С другой стороны – культивирование почти бесплатного использования продукта, вплоть до «взлома» его лицензионной защиты. Очевидно, последний подход чреват коллизиями и не может привести к успеху в долгосрочной работе.

Концепция сериализуемости

Концепции транзакции и механизма блокировок хорошо документированы в литературе [BHG, PAP, PON, GR]. В следующих нескольких абзацах делается обзор терминологии, используемой в этой области.Транзакцией называют упорядоченное множество операций, переводящих базу данных из одного согласованного состояния в другое. История моделирует перекрывающееся выполнение множества транзакций в виде линейно упорядоченной последовательности их операций чтения и записи (вставки, модификации, удаления) определенных элементов данных. Говорят, что две операции в истории конфликтуют, если они выполняются различными транзакциями над одним и тем же элементом данных, и хотя бы одна из них выполняет операцию записи этого элемента данных. Согласно [EGLT], это определение можно широко интерпретировать в зависимости от того, что понимать под "элементом данных". Это может быть строка таблицы, область страницы, целая таблица или коммуникационный объект, такой, например, как сообщение в очереди. Конфликтующие операции могут возникать не только на отдельных элементах данных, но и на множествах элементов данных, покрываемых предикатными блокировками.

Отдельная история приводит к образованию графа зависимостей (dependency graph), определяющего временные потоки данных между транзакциями. Операции зафиксированных транзакций представляются вершинами графа. Если в истории операция op1

транзакции T1 конфликтует с операцией op2 транзакции T2 предшествует этой операции, то пара

Анализ уровней изолированности ANSI SQL

Сначала сделаем позитивное замечание с том, что блокировочные уровни изолированности соответствуют требованиям ANSI SQL.Замечание 2. Блокировочные протоколы во определяют блокировочные уровни изолированности, которые, как минимум, сильны настолько же, как и соответствующие основанные на феноменах уровни изолированности в . Доказательство этого утверждения приводится в [OOBBGH].

Поэтому блокировочные уровни изолированности обеспечивают, по крайней мере, не меньшую изоляцию, чем одноименные ANSI-уровни. Могут ли они обеспечивать большую изоляцию? Ответ – да, даже на самом нижнем уровне. Чтобы избежать феномена, который мы называем "грязной записью" (Dirty Write), на Locking READ UNCOMMITTED обеспечивается долговременная блокировка по записи, тогда как в определениях ANSI SQL, основанных на аномалиях, такое аномальное поведение не исключается на всех уровнях, кроме ANSI SERIALIZABLE. "Грязное чтение" определяется следующим образом.

P0 (Грязная Запись): Транзакция T1 модифицирует некоторый элемент данных. После этого другая транзакция T2 тоже модифицирует этот элемент данных перед тем, как T1 выполнит COMMITT или ROLLBACK. Если T1 или T2 после этого выполнит ROLLBACK, то становится непонятным, каким должно быть корректное значение данных. Свободной интерпретацией этого является следующая история:

P0: w1[x]...w2[x]... ((c1 или a1) и (c2 или a2) в любом порядке)

Одной из причин, по которым феномена грязной записи следует избегать, является то, что он может нарушить согласованность базы данных. Предположим, что существует ограничение на значения элементов данных x и y (например x = y). Обе транзакции, и T1, и T2, поддерживают согласованность, если выполняются порознь. Однако ограничение легко может быть нарушено, если транзакции параллельно производят операции записи в x и y в разном порядке. Это может произойти, если не допускаются грязные записи. Например, если возможна история w1[x]...w2[x]...w2[y]...c2...w1[y]...c1

то "выживут" изменения, сделанные T1 в y, и изменения, сделанные T2 в x. Если T1 записывает в оба элемента x и y 1, а T2 – 2, то результатом будет x = 2, y = 1, что нарушает ограничение x=y.

В [GLPT, BHG] и других работах рассматривается необходимость защиты от феномена P0 для возможности автоматического отката транзакций. Без защиты от P0 система не может аннулировать изменения, просто восстановив предыдущие значения. Рассмотрим историю: w1[x]w2[x]a1

Аннулирование w1[x] и восстановление предыдущего значения x не являются удовлетворительными, потому что в результате такого восстановления уничтожится и изменение x w2[x], сделанное второй транзакцией. На если не аннулировать w1[x] путем восстанавления предыдущего значения x, и вторая транзакция тоже выполнит откат, то нельзя будет аннулировать изменение w2[x] путем восстановления его предыдущего значения x! Именно поэтому даже самые слабые блокировочные системы удерживают долговременную блокировку по записи. В противном случае не смогли бы работать их механизмы восстановления.

Замечание 3. Изолированность в ANSI SQL должна быть изменена таким образом, чтобы исключить P0 на всех уровнях изолированности.

Теперь мы приведем доводы в пользу того, почему требуются именно свободные интерпретации всех трех ANSI-феноменов. Напомним, что строгие интерпретации выглядят следующим образом:

A1: w1[x]...r2[x]... ((a1 и c2) в любом порядке) (грязное чтение)

A2: r1[x]...w2[x]...c2...r1[x]...c1 (размытое или неповторимое чтение)

A3: r1[P]...w2[y in P] ...c2...r1[P]...c1 (фантом)

Согласно , на уровне изолированности READ COMMITTED запрещаются аномалии A1, на уровне REPEATABLE READ – аномалии A1 и A2, и на уровне SERIALIZABLE – аномалии A1, и A2, и A3. Рассмотрим историю H1, в которой две транзакции производят перевод 40 долларов между строками x и y в банковском балансе:

H1: r1[x=50] w1[x=10] r2[x=10] r2[y=50] c2 r1[y=50] w1[y=90] c1

История H1 демонстрирует несериализуемую, классическую проблему анализа несогласованности

(inconsistent analysis), когда транзакция T1 переводит 40 долларов с x на y, сохраняя размер общей суммы баланса, равный 100, но транзакция T2

производит чтение в тот момент, когда баланс находится в несогласованном состоянии при общей сумме равной 60. История H1 не подходит ни под одну из аномалий A1, A2 и A3. В случае A1 одна из транзакций должна была бы завершиться аварийно; для A2 элемент данных должен был бы быть прочитан одной из транзакцией повторно; в случае A3 должна была бы измениться область истинности соответствующего предиката. Ни что из этого не происходит в H1. Рассмотрим свободную интерпретацию A1, феномен P1:

P1: w1[x]...r2[x]... ((c1 или a1) и (c2 или a2) в любом порядке)

H1 действительно нарушает P1. Поэтому для того, что подразумевалось в стандарте ANSI SQL, следует выбирать интерпретацию P1, а не A1. Именно свободная интерпретация является корректной.

Аналогичные доводы показывают, что для интерпретации второго ANSI-феномена следует выбирать интерпретацию P2, а не A2. Различия между A2 и P2 видны на примере следующей истории:

H2: r1[x=50] r2[x=50] w2[x=10] r2[y=50] w2[y=90] c2 r1[y=90] c1

H2 является несериализуемой – это еще одна проблема анализа несогласованности, где T2 видит общий баланс, равный 140. В этой истории ни одна транзакция не читает грязные (т.е. незафиксированные) данные. Таким образом, история не противоречит P1. Кроме того ни один элемент данных не читается дважды и нет изменяющейся области истинности соответствующего предиката. Проблема с H2 состоит в том, что T1 читает значение y, когда значение x уже устарело. Если бы T1 прочитала значение x снова, то оно бы обновилось, но она этого не делает, и A2 к этому случаю не подходит. Заменяя A2 на P2, т.е. свободную интерпретацию, мы решаем эту проблему:

P2: r1[x]...w2[x]... ((c1 или a1) и (c2 или a2) в любом порядке)

H2 будет отвегнута при попытке второй транзакции (w2[x=10]) перезаписать значение переменной, прочитанной до этого первой транзакцией r1[x=50]. И наконец, рассмотрим A3 и историю H3:

A3: r1[P]...w2[y in P] ...c2...r1[P]...c1 (фантом)

H3: r1[P] w2[insert y to P] r2[z] w2[z] c2 r1[z] c1

T1 осуществляет поиск по условию P=<> для получения списка служащих. После этого T2 производит вставку нового служащего и потом обновляет z – счетчик служащих в компании. Затем T1 читает значение счетчика служащих, проверяет и находит рассогласование. Ясно, что эта история несериализуема, но она допустима, поскольку не подходит под A3: никакой предикат не применяется дважды. Снова только свободная интерпретация решает проблему:

P3: r1[P]...w2[y in P]... ((c1 или a1) и (c2 или a2) в любом порядке)

Если запретить P3, то история H3 станет недопустимой. Ясно, что именно это подразумевалось в стандарте ANSI SQL. Дальнейшее обсуждение направлена на то, чтобы продемонстрировать полученные результаты.

Замечание 4. Строгие интерпретации A1, A2 и A3 имеют непредусмотренные недостатки. Правильными являются свободные интерпретации. Определяя P1, P2 и P3, мы полагаем, что в ANSI имелось в виду именно это.

Замечание 5. Множество феноменов ANSI SQL неполно. Может возникнуть ряд других аномалий. Чтобы сделать определение блокировок, необходимо определить новые феномены. Кроме того, необходимо переформулировать определение P3. В следующих определениях мы опускаем (c2 или a2), что не ограничивает возможные истории.

P0: w1[x]...w2[x]... (c1 или a1) (Dirty Write, грязная запись)

P1: w1[x]...r2[x]... (c1 или a1) (Dirty Read, грязное чтение)

P2: r1[x]...w2[x]... (c1 или a1) (Fuzzy or Non-Repeatable Read, размытое или неповторимое чтение)

P3: r1[P]...w2[y in P]... (c1 или a1) (Phantom, фантом)

Заметим, что определение P3, приведенное выше, отличается от определения P3 в ANSI SQL. Определение P3 в ANSI SQL запрещает только операции вставки (и модификации в соответствии с некоторыми интерпретациями), попадающие под область действия предиката, когда определение P3, приведенное выше, запрещает любую операцию записи (вставки, модификации, удаления), попадающую под предикат, по которому была произведена операция чтения.

Определения предложенных ANSI уровней изолированности в терминах этих феноменов приведены в таблице 3.

Таблица 3. Уровни изолированности ANSI, определенные в терминах четырех феноменов

|

Уровень изолированности |

Р0 грязная запись (Dirty Write) |

Р1 грязное чтение (Dirty Read) |

Р2 размытое чтение (Fuzzy Read) |

Р3 фантом (Phantom) |

|

ЧТЕНИЕ НЕЗАФИКСИРОВАННЫХ ДАННЫХ (READ UNCOMMITTED) |

невозможен |

возможен |

возможен |

возможен |

|

ЧТЕНИЕ ЗАФИКСИРОВАННЫХ ДАННЫХ (READ COMMITTED) |

невозможен |

невозможен |

возможен |

возможен |

|

ПОВТОРИМОЕ ЧТЕНИЕ (REPEATABLE READ) |

невозможен |

невозможен |

невозможен |

возможен |

|

СЕРИАЛИЗУЕМОСТЬ (SERIALIZABLE) |

невозможен |

невозможен |

невозможен |

невозможен |

Замечание 6. Определения блокировочных уровней изолированности в эквивалентны феноменологическим определениям в . Другими словами, P0, P1, P2 и P3 являются замаскированнымии определениями блокировочного поведения.

В дальнейшем мы будем ссылаться на уровни изолированности, перечисленные в , по их именам из этой таблицы, подразумевая их эквивалентность блокировочным уровням изолированности из . Когда мы будем употребляем термины ANSI READ UNCOMMITTED, ANSI READ COMMITTED, ANSI REPEATABLE READ и ANOMALY SERIALIZABLE, будут иметься в виду определения ANSI из (недостаточной, т.к. она не включает P0)

В следующем разделе показывается, что в ряде коммерческих реализаций изолированности обеспечиваются уровни изолированности, которые попадают между уровнями READ COMMITTED и REPEATABLE READ. Для получения осмысленных уровней изолированности, которые позволили бы четко различить эти реализации, мы примем P0 и P1 в качестве базиса, а затем добавим новые зарактерные феномены.

Благодарности

Мы выражаем благодарность Крису Ларсону (Chris Larson) из Microsoft, Алану Рейтеру (Alan Reiter), которые нашли несколько новых аномалий в ИЗОЛИРОВАННОСТИ ОБРАЗА, Франко Путзолу (Franco Putzolu) и Анил Нори (Anil Nori) из Oracle, Майку Убеллу (Mike Ubell) из компании Illustra и всем анонимным рефери из SIGMOD за ценные предложения, которые улучшили эту статью. Сашил Джодиа (Sushil Jajodia), V.Atluri и E.Bertino, которые прислали нам черновой вариант своей работы [ABJ], касающейся уровней ограниченной изолированности для многоверсионных историй.Другие многоверсионные системы

Существуют другие модели многоверсионности. В некоторых коммерческих продуктах поддерживаются версии объектов, но ограничивают область применения метода Snapshot Isolation только читающими транзакциями. (Например, SQL-92, Rdb и SET TRANSACTION READ ONLY в некоторых других базах данных [MS, HOB, DRA]; в Postgres и Illustra [STO, ILL] такие версии поддерживаются долговременно (long-term), и обеспечивается возможность темпоральных запросов.) В других реализациях допускаются изменяющие транзакции, но не поддерживается защита "Выигрывает первая зафиксированная транзакция" (например, уровень изолированности READ CONSISTENCY в Oracle [ORA]).На уровне READ CONSISTENCY в Oracle каждому SQL-оператору перед началом его выполнения дается самое свежее зафиксированное состояние базы данных. Это похоже на то, как если бы стартовая временная метка транзакции снималасьдля каждого SQL-оператора. Множество строк курсора формируется во время выполнения операции открытия курсора. Базовый механизм заново вычисляет подходящую версию строки на основе временной метки оператора. Операции вставки, модификации и удаления строк защищаются блокировками по записи, что приводит к политике "Выигрывает первая записавшая транзакция", а не к "Выигрывает первая зафиксированная транзакция". Уровень READ CONSISTENCY сильнее, чем READ COMMITTED (на нем исключается потеря изменений по курсору (P4C)), но допускает неповторимое чтение (P3), потерю изменений в общем случае (P4) и искажение чтения (A5A). Snapshot Isolation не допускает P4 и A5A.

Если пристально посмотреть на стандарт SQL, то можно сказать, что он трактует каждый оператор как атомарный. В начале каждого оператора имеется сериализуемая подтранзакция (или временная метка). Можно представить иерархию уровней изолированности, определяемых различными вариантами комбинации оператора и присоединенной к нему временной меткой. (Например, в Oracle, операция чтения по курсору имеет временнуя метку, снятую в момент открытия курсора.)

Изолированность на основе моментальных снимков

Транзакция, выполняемая на уровне изолированности на основе моментальных снимков (Snapshot Isolation), всегда читает данные из моментального снимка (зафиксированных) данных, произведенного в момент начала транзакции, который называется стартовой временной меткой (Start-Timestamp). В качестве этого момента может быть выбран любой момент до выполнения этой транзакцией первого чтения. Транзакции, выполняемая на уровне Snapshot Isolation, никогда не блокируется при попытке произвести чтение до тех пор, пока можно поддерживать данные моментального снимка, соответствующего стартовой временной метке. В этом моментальном снимке также отражаются результаты всех операций записи (модификация, вставка и удаление) данной транзакции, используемые при повторном обращении этой транзакции (по чтению или записи) к тем же элементам данных. Изменения, производимые другими транзакциями после момента стартовой временной метки, для данной транзакции являются невидимыми.Snapshot Isolation является разновидностью многоверсионных механизмов управления параллельными транзакциями (multiversion concurrency control). Он расширяет многоверсионный смешанный метод (Multiversion Mixed Method), описанный в [BHG], в котором допускается чтение данных из моментального снимка для только читающих транзакций.

Когда транзакция T1 становится готовой к фиксации, она получает временную метку фиксации (Commit-Timestamp), которая должна быть больше любой существующей Start-Timestamp и Commit-Timestamp. Транзакции T1 успешно фиксируется только в том случае, если ни одна другая транзакция T2 c Commit-Timestamp, попадающей в интервал [Start-Timestamp, Commit-Timestamp] транзакции T1, не записала в те же элементы данных, что и T1. В противном случае T1 завершается аварийно. Этот метод, называемый "Выигрывает первая зафиксированная транзакция" (First-committer-wins), устраняет потерянные изменения (феномен P4). Когда транзакция T1 фиксируется, ее изменения становятся видны всем транзакциям, у которых Start-Timestamp больше, чем Commit-Timestamp транзакции T1.

Нарушение ограничения (constrant violation) является типичным и важным типом аномалий, возникающих при параллельном выполнении транзакций. Индивидуальные базы данных удовлетворяют ограничениям, задаваемым на множествах элементов данных (например уникальность ключей, целостность ссылок, репликация строк в двух таблицах и т.д.). Все вместе они образуют неизменяемый ограничительный предикат базы данных C(DB). Предикат принимает значение True, если состояние базы данных DB согласуется с ограничениями False в противном случае. Для поддержки согласованности базы данных транзакции должны сохранять истинность ограничительного предиката: если база данных является согласованным до начала транзакции, то она останется согласованной и после ее фиксации. Если транзакция читает содержимое базы данных, нарушающее ограничительный предикат, то она испытывает аномалию нарушения ограничения из-за наличия параллельно выполняемой транзакции. Подобные нарушения ограничений называются анализом несогласованности (inconsistent analysis) [DAT].

A5 (Нарушение ограничения на элементах данных). Предположим, что C()

– ограничение между двумя элементами данных x и y из базы данных. Ниже приводятся две аномалии, возникающие при нарушении ограничения.

A5A (Искажение чтения, Read Skew). Предположим, что транзакция T1 читает x, а затем другая транзакция T2 изменяет значения x и y и фиксируется. Если теперь T1 прочитает значение y, она может обнаружить несогласованное состояние, и поэтому она произведет тоже несогласованное состояние. В терминах историй мы имеем аномалию:

A5A: r1[x]...w2[x]...w2[y]... c2...r1[y]...(c1 или a1) (искажение чтения, Read Skew)

A5B (Искажение записи, Write Skew). Предположим, что транзакция T1 читает x и y, которые согласованы в соответствии с предикатом C(), а затем другая транзакция T2 читает значения x и y, записывает x и фиксируется. После этого T1

записывает y. Если на x и y было какое-нибудь ограничение, то оно может нарушиться. В терминах историй:

A5B: r1[x]...r2[y]...w1[y]... w2[x]...(c1 или c2) (искажение записи, Write Skew)

Феномен размытого чтения (P2) является частным случаем искажения чтения, где x=y. Более часто в транзакции читаются два разных, но взаимозависимых элемента (например, поддерживается целостность ссылок). Искажение записи (Write Skew) (A5B) может возникнуть при наличии ограничения в банке, когда балансам счетов разрешается быть отрицательными, пока сумма совместно поддерживаемых балансов остается положительной. Это приводит к такой аномалии, как в истории H5.

Понятно, что ни аномалия A5A, ни A5B не могла бы возникнуть в историях с исключенным феноменом P2, поскольку в обоих случаях транзакция T2записывает элемент данных, предварительно прочитанный незафиксированной транзакцией T1. Поэтому феномены A5A и A5B полезны только для классификации уровней изолированности, более слабых, чем REPEATABLE READ.

В ANSI SQL определение уровня REPEATABLE READ в строгой интерпретации позволяет поддерживать частные случаи ограничений на строках, но в нем отсутствует общая концепция. Более конкретно, Locking REPEATABLE READ из обеспечивает защиту от нарушения ограничений на строках (row constraint violations), а определение ANSI SQL из , запрещая аномалии A1 и A2, – нет.

Возвращаясь к обсуждению уровня изолированности Snapshot Isolation, следует заметить, что он поразительно силен, даже сильнее, чем READ COMMITTED.

Замечание 8. READ COMMITTED << Snapshot Isolation

Доказательство. На уровне Snapshot Isolation механизм "выигрывает первая зафиксированная транзакция" устраняет феномен P0 (грязная запись), а механизм временных меток не допускает возникновение феномена P1 (грязное чтение). Отсюда следует, что Snapshot Isolation не слабее, чем READ COMMITTED. Кроме того, на уровне READ COMMITTED возможен феномен A5A, но он невозможен при использовании механизма временных меток на уровне Snapshot Isolation. Следовательно, READ COMMITTED << Snapshot Isolation.

Заметим, что в одноверсионной интерпретации сложно описать, как в историях на уровне Snapshot Isolation можно избежать феномена P2. Аномалия A2 произойти не может, так как транзакция на уровне Snapshot Isolation будут читать одно и то же значение элемента данных даже в том случае, когда в промежутках между чтениями этот элемент изменяется другой транзакцией. Очевидно, что в истории на уровне Snapshot Isolation может произойти аномалия искажение записи (A5B) (например, в истории H5), а в одноверсионной интерпретации историй запрещет феномена P2 устраняет A5B. Поэтому на уровне Snapshot Isolation допускаются истории с аномалиями, которые не допустимы на уровне REPEATABLE READ.

На уровне Snapshot Isolation невозможна аномалия A3. При повторном чтении транзакции по предикату после изменения данных другой транзакцией будет всегда выдаваться тот же самый старый набор данных. Но на уровне REPEATABLE READ аномалии вида A3 возможны. Snapshot Isolation не допускает историй с аномалией A3, но допускает истории с аномалией A5B, а у REPEATABLE READ все наоборот. Следовательно:

Замечание 9. REPEATABLE READ >><< Snapshot Isolation

Однако Snapshot Isolation не устраняет P3. Рассмотрим следующее ограничение: для множества рабочих заданий, определяемых предикатом, общая продолжительность этих заданий не должна превышать 8 часов. T1 читает по этому предикату, определяет, что общая продолжительность равна 7 часам и добавляет новое задание продолжительностью 1 час. Конкурирующая транзакция T2 делает то же самое. Поскольку обе транзакции вставляют разные элементы данных (а также разные значения ключей индексов, если таковые имеются), такой сценарий не устраняется механизмом "выигрывает первая зафиксированная транзакция" и может иметь место на уровне Snapshot Isolation. Но в любой эквивалентной последовательной истории такой сценарий привел бы к возникновению феномена P3.

Возможно, наиболее замечательно то, что на уровне Snapshot Isolation отсутствуют фантомы (в строгой интерпретации A3 определения ANSI). Каждая транзакция никогда не видит изменений, производимых параллельно выполняемыми транзакциями. Таким образом, без дополнительных ограничений в подразделе 4.28 в [ANSI] можно сформулировать следующий поразительный результат: (напомним, что в ANOMALY SERIALIZABLE соответствует определению ANSI SQL SERIALIZABLE)).

Замечание 10. В историях на уровне Snapshot Isolation устраняются аномалии A1, A2 и A3. Следовательно, в аномальной интерпретации ANOMALY SERIALIZABLE из ANOMALY SERIALIZABLE << Snapshot Isolation.

На уровне Snapshot Isolation разрешается выполняться транзакциям с очень старыми временными метками, что позволяет им совершать путешествия во времени, вопринимая исторические аспекты базы данных, не блокируя транзакции, изменяющие базу данных, и не блокируясь такими транзакциями. Конечно, если транзакции с очень старыми временными метками, попытались бы изменять данные, уже измененные более молодыми транзакциями транзакциями, они были бы завершены аварийным образом.

Достаточно простая реализация механизма Snapshot Isolation была предложена Ридом (Reed) в [REE]. Существует несколько коммерческих реализаций таких многоверсионных баз данных. В InterBase 4 фирмы Borland [THA] и сервере, лежащем в основе Exchange System компании Microsoft, обеспечивается Snapshot Isolation с механизмом "Выигрывает первая зафиксированная транзакция". Этот механизм заставляет систему помнить все изменения (блокировки по записи), принадлежащие каждой транзакции, которая фиксируется после снятия стартовой временной метки каждой активной транзакции. Транзакция завершается аварийным образом, если ее изменения конфликтуют с запомненными изменениями других транзакций.

"Оптимистический" подход Snapshot Isolation к управлению параллельным выполнением транзакций имеет очевидное преимущество для только читающих транзакций, но его преимущества для изменяющих транзакций до сих пор обсуждаются. Возможно, этот метод не подходит для долговременных изменяющих данные транзакций, конкурирующих с высоко состязательными кратковременными транзакциями. Кратковременные транзакции будут фиксировать свои модификации быстрее и, следовательно, поскольку "выигрывает первая зафиксировавшаяся транзакция", долговременные транзакции, вероятнее всего, будут постоянно откатываться. (Заметим, что такой сценарий привел бы к реальной пролеме и в блокировочных реализациях, а если принять решение не использовать долговременные изменяющие транзакции, то будет применим и подход Snapshot Isolation.) Конечно, в случае, когда кратковременные транзакции конфликтуют минимально, а долговременные ndash; только читают данные, подход Snapshot Isolation должен дать хорошие результаты. В случае сильной конкуренции между транзакциями сопоставимой длины Snapshot Isolation представляет собой классический оптимистический подход. Мнения относительно его полезности расходятся.

Критика уровней изолированности в стандарте ANSI SQL

Х. Беренсон, Ф. Бернштейн, Д. Грэй, Д. Мелтон, Э. О'Нил, П. О'НилИсточник: журнал Системы Управления Базами Данных # 2/1996, издательский дом «Открытые системы»

Новая редакция: Сергей Кузнецов, 2009 г.

Оригинал: Hal Berenson, Phil Bernstein, Jim Gray, Jim Melton, Elizabeth O’Neil, Patrick O'Neil. Critique of ANSI SQL Isolation Levels. Proceeding of the ACM SIGMOD International Conference, May, 1995. Текст доступен здесь.

В ANSI SQL-92 [MS, ANSI] уровни изолированности (Isolation Levels) определяются в терминах феноменов (phenomena): грязное чтение (Dirty Read), неповторимое чтение (Non-repeatable Read) и фантомы (Phantom). В статье показывается недостаточность феноменов и определений ANSI SQL для надлежащего описания нескольких популярных уровней изолированности, включая стандартные блокировочные реализации рассматриваемых уровней. Исследуется неоднозначность определений феноменов и дается более точное формальное определение феномена. Вводятся новые феномены, которые лучше характеризуют предлагаемые типы изолированности. Определяется новый тип многоверсионной изолированности называемый изолированностью на основе моментальных снимков (Snapshot Isolation).

Механизм блокировок

В большинстве SQL-продуктов изолированность реализована на основе механизма блокировок. Поэтому полезно описать уровни изолированности ANSI SQL в терминах блокировок, хотя при этом возникают некоторые проблемы.Выполнение транзакций происходит под управлением планировщика блокировок. Перед выполнением операции чтения или записи над отдельными элементами данных или множеством элементов данных транзакция делает запрос планировщику блокировок на установление соответствующей блокировки по чтению (Share) или записи (Exclusive). Две блокировки, запрошенные различными транзакциями на одном и том же элементе данных, конфликтуют, если хотя бы одна из них является блокировкой по записи.

Предикатная блокировка по чтению (записи) множества элементов данных, определяемого задаваемым условием

Транзакция обладает правильно построенными (well-formed writes) записями (чтениями), если она запрашивает блокировку по записи (чтению) каждого элемента данных или предиката перед выполнением операции записи (чтения) этого элемента данных или множества элементов данных, определяемого предикатов. Транзакция называется правильно построенной (well-formed), если правильно построены все ее операции записи и чтения. Транзакция обладает двухфазными (two-phase writes) записями (чтениями), если она не устанавливает новую блокировку по записи (чтению) на элемент данных после снятия с него блокировки по записи (чтению). Транзакция осуществляет двухфазное блокирование (two-phase locking), если она не запрашивает новeю блокировку (по записи или чтению) после снятия какой-либо блокировки.

Блокировка, запрашиваемая транзакцией, называется долговременной (long duration), если она не снимается до конца транзакции (фиксации или аварийного завершения). В противном случае блокировка называется кратковременной (short duration). На практике кратковременные блокировки обычно снимаются сразу же после завершения операции.

Если одна транзакция удерживает блокировку, а другая транзакция запрашивает установку конфликтующей блокировки, то этот запрос не удовлетворяется до тех пор, пока конфликтующая блокировка первой транзакции не будет освобождена.

Фундаментальная теорема сериализуемости гласит, что правильно построенное двухфазное блокирование гарантирует сериализуемость – каждая история, порождаемая двухфазным блокированием, эквивалентна некоторой последовательной истории. Наоборот, если транзакция не является правильно построенной или не осуществляет двухфазное блокирование, то возможны несериализуемые истории выполнения [EGLT]. Исключения составляют только вырожденные случаи.

В стремлении показать эквивалентность блокировок, зависимостей и формализмов, основанных на аномалиях, в статье [GLPT] определялись четыре степени согласованности (degrees of consistency). Определения аномалий (см. определение 1) были слишком расплывчатыми. Авторов этой статьи продолжают критиковать за этот аспект определений (см. также [GR]). Испытание временем смогли выдержать только более строгие математические определения в терминах историй, графов зависимостей и блокировок.

|

Уровень согласованности = Блокировочный уровень изолированности |

Блокировки по чтению на элементах данных и предикатах (одинаковы, если нет замечаний) |

Блокировки по записи на элементах данных и предикатах (везде одинаковы) |

|

Степень 0 |

Ничего не требуется |

Правильно построенные записи |

|

Степень 1 = блокировочное чтение незафиксированных данных (Locking READ UNCOMMllTED) |

Ничего не требуется |

Правильно построенные записи Долговременные блокировки по записи |

|

Степень 2 = Блокировочное чтение зафиксированных данных (Locking READ COMMITTED) |

Правильно построенные чтения Кратковременные блокировки по чтению (в обоих случаях) |

Правильно построенные записи Долговременные блокировки по записи |

|

Устойчивость курсора (см. разд. 4.1) (Cursor Stability) |

Правильно построенные чтения Блокировка по чтению удерживается на текущем элементе курсора Кратковременные предикатные блокировки по чтению |

Правильно построенные записи Долговременные блокировки по записи |

|

Блокировочное повторимое чтение (Locking REPEATABLE READ) |

Правильно построенные чтения Долговременные блокировки по чтению на элементах данных Кратковременные предикатные блокировки по чтению |

Правильно построенные записи Долговременные блокировки по записи |

|

Степень 3 = Блокировочная сериализуемость (Locking SERIALIZABLE) |

Правильно построенные чтения Долговременные блокировки по чтению (в обоих случаях) |

Правильно построенные записи Долговременные блокировки по записи |

Во таблице 2 определяется несколько типов изолированности в следующих терминах: области действия блокировок (элементы или предикаты), режимы (по чтению или по записи) и продолжительность (кратковременные или долговременные). Мы полагаем, что блокировочные уровни изолированности, называемые блокировочным чтением незафиксированных данных (Locking READ UNCOMMITTED), блокировочным чтением зафиксированных данных (Locking READ COMMITTED), блокировочным повторимым чтением (Locking REPEATABLE READ) и блокировочной сериализуемостью (Locking SERIALIZABLE), подразумевались в определениях уровней изолированности ANSI SQL, но, как демонстрируется позже в этой статье, они существенно отличаются от тех, которые перечислены в . Следовательно, необходимо различать уровни изолированности, определяемые в терминах блокировок, и уровни изолированности ANSI SQL, определяемые с помощью феноменов. Поэтому названия уровней изолированности в имеют префикс "Блокировочные", а в – "ANSI".

В [GLPT] определяется согласованность Степени 0, на которой разрешаются грязное чтение и запись (Dirty Reads and Writes). Требуется только атомарность операций. Степени 1, 2 и 3 аналогичны Locking READ UNCOMMITTED, Locking READ COMMITTED и Locking SERIALIZABLE соответственно. Ни одна степень согласованности не соответствует уровню изолированности Locking REPEATABLE READ.

Дейт и IBM [DAT, DB2] поначалу использовали термин "повторимые чтения" (Repeatable Reads) для обозначения сериализуемости или блокировочной сериализуемости. Этот термин кажется более понятным, чем термин "третья степень изолированности" [GLPT], хотя по значению они идентичны. Значение термина ANSI SQL REPEATABLE READ отличается от значения оригинального определения, данного Дэйтом, и мы полагаем, что принятая в ANSI SQL терминология является неудачной. Поскольку аномалия P3 специальным образом не исключается на уровне изолированности ANSI SQL REPEATABLE READ, из определения P3 ясно, что чтения НЕ являются повторимыми! В мы продолжаем неправильно использовать этот термин в Locking REPEATABLE READ, чтобы соответствовать определению ANSI. Аналогично, Дейт ввел термин "устойчивость курсора" (Cursor Stability) как более понятное название для второй степени изолированности с дополнительной защитой от потерянных изменений через курсор, как объясняется ниже в подразделе 4.1 ниже.

Определение. Уровень изолированности L1 слабее (weaker) уровня изолированности L2 (или L2 сильнее (stronger), чем L1; обозначим это как L1 << L2), если все несериализуемые истории, удовлетворяющие критериям уровня L2, также удовлетворяют критериям уровня L1, и существует хотя бы одна несериализуемая история, возможная на уровне L1 и невозможная на уровне L2. Два уровня изолированности L1 и L2 эквивалентны (equivalent), что обозначается как L1 == L2, если множества допустимых несериализуемых историй на уровнях L1 и L2 идентичны. L1 не сильнее (no stronger), L2, что обозначается как L1 << L2, если L1 << L2 или L1 == L2. Два уровня изолированности несравнимы (incomparable), что обозначается как L1 >><< L2, когда каждый уровень изолированности допускает несериализуемую историю, недопустимую на другом уровне.

Сравнивая уровни изолированности, мы различаем их только по несериализуемым историям, которые могут произойти на одном уровне и невозможны на другом. Два уровня изолированности могут также различаться по тем сериализуемым историям, которые они допускают, но мы считаем, что Locking SERIALIZABLE == Serializable, хотя хорошо известно, что блокировочный планировщик не допускает все возможные сериализуемые истории. Возможно, такие уровни изолированности несколько непрактичны, поскольку не допускают слишком много сериализуемых историй, но мы здесь этот вопрос не рассматриваем.

Эти определения приводят к слудующему замечанию.

Замечание 1.

Locking READ UNCOMMITTED << Locking READ COMMITTED << Locking REPEATABLE READ << Locking SERIALIZABLE

В следующем разделе мы сравним определения ANSI с блокировочными определениями.

Резюме и Выводы

Подводя итоги, можно сказать, что оригинальные определения уровней изолированности в ANSI SQL имеют серьезные недостатки (как пояснялось в разд. 3). Словесные определения противоречивы и неполны. Не исключается феномен грязной записи (P0). В Замечании 5 мы даем рекомендации по тому, как модифицировать определения уровней изолированности ANSI SQL, чтобы сделать их эквивалентными блокировочным уровням изолированности в [GLPT].В ANSI SQL уровень изолированности REPEATABLE READ мыслился как уровень, на котором исключаются все аномалии, кроме фантомов. Определение, данное в терминах аномалий в , не достигает этой цели, в отличие от блокировочного определения из . Выбор ANSI-термина REPEATABLE READ является вдвойне неудачным: (1) повторяемые чтения не дают повторяемых результатов; (2) в индустрии этот термин уже занят, и в некоторых продуктах повторимое чтение означает сериализуемость. Мы рекомендуем найти для этого уровня новое название.

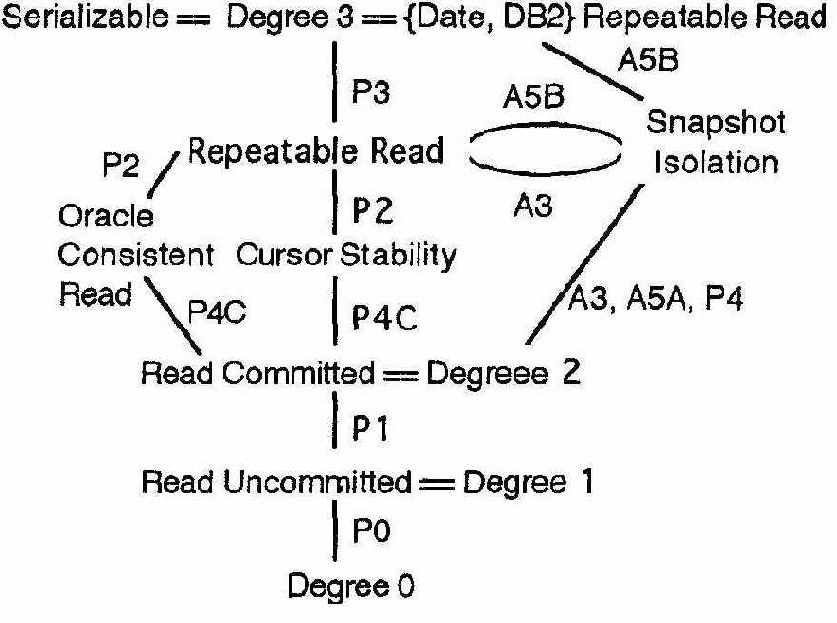

Некоторые коммерчески популярные уровни изолированности, по степени изолированности попадающие в интервал между уровнями REPEATABLE READ и SERIALIZABLE из , в разд. 4 охарактеризованы новыми феноменами и аномалиями. Все уровни изолированности, о которых упоминается в этой статье, можно классифицировать, как показано на рис. 1 и в . Чем выше на рисунке расположен уровень, тем он сильнее (см. определение в начале подраздела 4.1). Уровни соединены линиями, помеченными феноменами или аномалиями, которые отличают один уровень от другого.

Рисунок 1. Диаграмма уровней изолированности и их взаимосвязей. Предполагается, что уровни изолированности ANSI SQL усилены в соответствии с замечанием 5 и таблицей 3. Дуги аннотированы названиями феноменов, отличающих уровни изолированности. Не показана потенциальная многоверсионная иерархия, расширяющая Snapshot Isolation на более слабые степени изолированности путем установки временных меток на пооператорной основе. Также не показаны исходные уровни изолированности ANSI SQL, основанные на строгой интерпретации феноменов P1, P2 и P3.

Таблица 4. Типы изолированности, характеризуемые возможными допустимыми аномалиями

|

Уровень изолированности |

Р0 Dirty Write |

Р1 Dirty Read |

Р4С Cursor Lost Update |

P4 Lost Update |

Р2 Fuzzy Read |

Р3 Phantom |

A5A Read Skew |

A5B Write Skew |

|

READ UNCOMMITTED == Степень 1 |

невозможен |

возможен |

возможен |

возможен |

возможен |

возможен |

возможен |

возможен |

|

READ COMMITTED == Степень 2 |

невозможен |

невозможен |

возможен |

возможен |

возможен |

возможен |

возможен |

возможен |

|

CURSOR STABILITY |

невозможен |

невозможен |

невозможен |

иногда возможен |

иногда возможен |

возможен |

возможен |

иногда возможен |

|

REPEATABLE READ |

невозможен |

невозможен |

невозможен |

невозможен |

невозможен |

возможен |

невозможен |

невозможен |

|

SNAPSHOT ISOLATION |

невозможен |

невозможен |

невозможен |

невозможен |

невозможен |

иногда возможен |

невозможен |

возможен |

|

ANSI SQL SERIALIZABLE == Степень 3 == Repeatable Read Дейт, IBM, Tandem,... |

невозможен |

невозможен |

невозможен |

невозможен |

невозможен |

невозможен |

невозможен |

невозможен |

Заметим, что уровни ограниченной изолированности для многоверсионных систем никогда раньше не классифицировались, хотя реализованы в нескольких продуктах. Во многих приложениях состязания за блокировки избегаются путем использования уровней изолированности типа Cursor Stability или Read Consistency в Oracle. Snapshot Isolation имеет лучшие характеристики, чем любой из таких уровней: исключаются аномалия потерянных изменений, некоторые фантомные аномалии (например описанная в ANSI SQL), никогда не блокируются только читающие транзакции, и они не блокируют изменяющие транзакции.

Уровни изолированности в ANSI SQL

Разработчики ANSI SQL дали такое определение изолированности, которое допускает широкий спектр механизмов реализации, не только механизм блокировки. Они определили изолированность с помощью следующих трех феноменов (phenomena):P1 (грязное чтение, Dirty Read): Транзакция T1 модифицирует некоторый элемент данных. После этого другая транзакция T2 читает содержимое этого элемента данных до того, как транзакция T1 выполняет операцию COMMIT (фиксируется) или ROLLBACK

(откатывается). Если T1 затем завершается операцией ROLLBACK, то получается, что транзакция T2 прочитала элемент данных, который никогда не фиксировался и, значит, никогда реально не существовал.

P2 (неповторимое, или размытое чтение, Non-repeatable or Fuzzy Read): Транзакция T1 читает некоторый элемент данных. После этого другая транзакция T2 модифицирует или удаляет этот элемент данных и фиксируется. Если T1 после этого попытается прочитать этот элемент данных снова, то она получит другое значение или обнаружит, что элемент данных больше не существует.

P3 (фантомы, Phantom): Транзакция T1 читает набор элементов данных, удовлетворяющих некоторому условию

создает элемент данных, удовлетворяющий этому условию, и фиксируется. Если транзакция T1 повторит чтение с тем же условием

Ни один из этих феноменов не может произойти в последовательной истории. Поэтому, по теореме о сериализуемости, они не могут произойти и в сериализуемой истории [EGLT, BHG Теорема 3.6, GR Раздел 7.5.8.2, PON Теорема 9.4.2].

Истории, состоящие из операций чтения, записи, фиксации и отката, могут быть записаны в сокращенной нотации: "w1[x]" обозначает операцию записи транзакции 1 в элемент данных x (таким образом данные "модифицируются"), а "r2[x]" представляет операцию чтения x в транзакции 2. Операции чтения и записи в транзакции 1 множества записей, удовлетворяющих предикату P, обозначаются r1[P] и w1[P] соответственно. Фиксация (COMMIT) и откат (ROLLBACK) транзакции 1 обозначаются "c1" и "a1" соответственно.

Феномен P1 может быть переформулирован как запрет на следующего сценария:

(2.1) w1[x]...r2[x]... (a1 и c2 в любом порядке)

Словесное определение феномена P1 неоднозначно. Оно в действительности не настаивает на том, чтобы T1 заканчивалась аварийным образом, а только утверждает, что если это произойдет, то может случиться что-то плохое. Некоторые люди интерпретируют P1 как:

(2.2) w1[x]...r2[x]... ((c1 или a1) и (c2 или a2) в любом порядке)

Если запретить P1 в варианте (2.2), то не будет допускаться любая история, в которой T1 модифицирует элемент данных x, а затем T2 читает элемент данных x до того как T1 зафиксируется или откатится. Не требуется, чтобы T1 завершалась аварийно, или чтобы T2 фиксировалась.

Определение (2.2) является намного более свободной интерпретацией P1, чем (2.1), поскольку оно запрещает все четыре возможных варианта пар фиксация-откат транзакций T1 и T2, когда в (2.1) запрещаются только две пары из четырех. Интерпретация (2.2) феномена P1 запрещает все варианты последовательности выполнения, в которых что-то аномальное могло бы произойти в будущем. Мы называем интерпретацию (2.2) свободной интерпретацией P1, а (2.1) – строгой интерпретацией

P1. Интерпретация (2.2) определяет феномен, который может привести к аномалии, а (2.1) определяет реальную аномалию. Обозначим их P1 и A1 соответственно. Тогда:

P1: w1[x]...r2[x]... ((c1 или a1) и (c2 или a2) в любом порядке) A1: w1[x]...r2[x]... ((a1 и c2) в любом порядке)

Аналогично, словесные определения феноменов P2 и P3 тоже имеют свободную и строгую интерпретации. Обозначим свободные интерпретации через P2 и P3, а строгие через A2 и A3:

P2: r1[x]...w2[x]... ((c1 или a1) и (c2 или a2) в любом порядке) A2: r1[x]...w2[x]...c2...r1[x]...c1 P3: r1[P]...w2[y in P]... ((c1 или a1) и (c2 или a2) в любом порядке) A3: r1[P]...w2[y in P] ...c2...r1[P]...c1

В третьем разделе все варианты интерпретаций феноменов рассматриваются более подробно. Аргументируется необходимость выбора свободных интерпретаций. Заметим, что в словесном ANSI SQL определении феномена P3 после чтения множества элементов данных, удовлетворяющих предикату P, запрещается только вставлять данные, которые попадают в область действия этого предиката, а в определении P3, которое было приведено выше, запрещается производить любую операцию записи (вставку, обновление, удаление), влияющую на кортеж, который удовлетворяет предикату.

Далее в статье рассматривается концепция многозначной истории (multi-valued history, MV-история, см. [BHG], Глава 5). Если не вдаваться в детали, в многоверсионной системе может одновременно существовать несколько версий одного элемента данных. При каждом чтения должно быть совершенно ясно, какую версию данных следует читать. Известны попытки связать определения изолированности ANSI с многоверсионными системами, а также с более распространенными одноверсионными системами (single-version) (SV-истории) стандартного блокировочного планировщика. Тем не менее, словесные определения феноменов P1, P2 и P3 подразумевают одноверсионные истории. В следующем разделе показано, как мы их интерпретируем.